进行以下操作时别忘记先关闭Hadoop集群

一. 没有SecondaryNode的解决方案

启动hadoop集群后没有SecondaryNode:

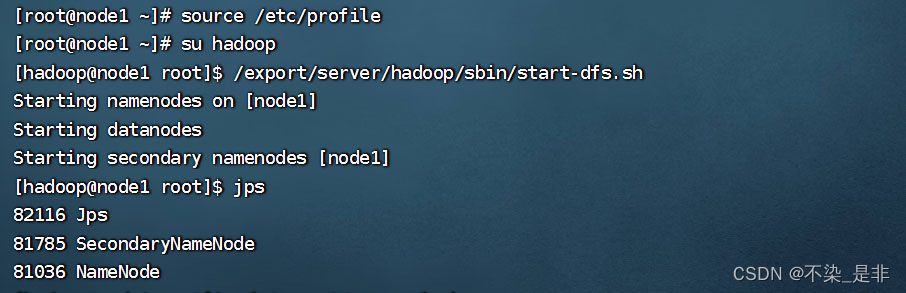

给hadoop集群配置环境变量时,在node1、node2、node3修改/etc/profile 忘记执行source /etc/profile生效

启动Hadoop集群再jps检查进程

这样就有了SecondaryNode进程

二. 没有DataNode的解决方案

启动hadoop集群后没有DataNode:

以root用户或权限 删除到Hadoop安装目录下的logs下的所有文件

再删除data下的nn下的所有文件和data下的dn下的所有文件

删除完后记得回到hadoop用户(我是新建了个hadoop用户防止以root用户启动hadoop出现问题)格式化namenode再启动hadoop集群

如果不格式化namenode就会出现如下情况(namenode进程未启动)

三. 没有NameNode的解决方案

启动hadoop集群后没有NameNode:

格式化namenode再启动hadoop集群

至此Hadoop成功启动